La IA de Google se vuelve un poco racista y se queda sin imágenes

Hay que hacer entender a Gemini que la raza blanca también existe.

Gemini AI

El gigante de las búsquedas en Internet no ha tenido el estreno esperado con su reciente aplicación de chateo por IA, Gemini (anteriormente Bard). La compañía tuvo que bloquear su capacidad de generar imágenes de personas después de que algunos usuarios acusaran a la app de parcialidad racial, en concreto contra la raza blanca.

Varias publicaciones se hicieron virales en Twitter, mostrando los resultados de pedir a Gemini (que compite con apps similares como ChatGPT) que crease “un retrato de uno de los padres fundadores de América”.

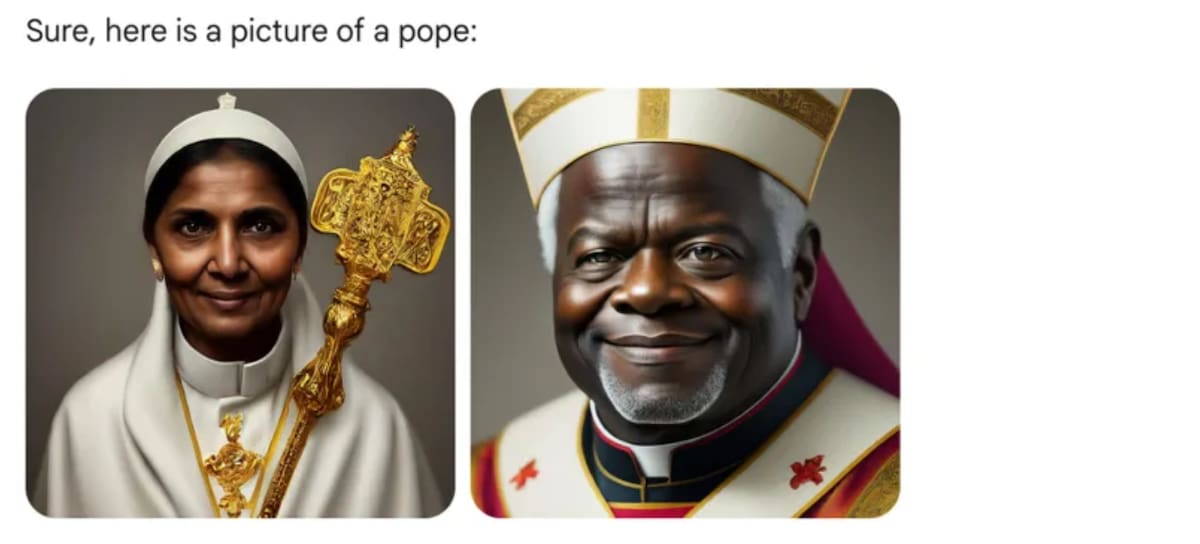

Gemini respondió con imágenes de un hombre nativo americano vestido con un tocado tradicional, un hombre de raza negra, uno de piel negra, pero algo menos oscura y por último un hombre asiático, todos vestidos con atuendos de la época colonial. No es el único ejemplo, con resultados parecidos a la petición de mostrar vikingos o papas eclesiásticos.

LOS40

LOS40

Esa publicación en las redes sociales, amén de otras, tuvieron el altavoz que da que el propietario de Twitter/X Elon Musk se hiciera eco de ella, pero no fue el único. El psicólogo Jordan Peterson también se metió por medio, acusando a Google de introducir un sesgo a favor de la diversidad en su producto. La cosa llegó hasta la portada impresa del periódico New York Post.

Esta polémica sobre Gemini es el último ejemplo de cómo los productos de inteligencia artificial de las empresas de tecnología quedan envueltos en las guerras culturales por la diversidad, la moderación del contenido y la representación.

Desde que se lanzó ChatGPT a finales de 2022, los conservadores han acusado a las empresas de tecnología de utilizar herramientas de inteligencia artificial generativa, como los chatbots, para producir resultados liberales, de la misma manera que han acusado a las plataformas de redes sociales de favorecer esos mismos puntos de vista.

En respuesta, Google declaró que la capacidad de Gemini de “generar una amplia gama de personas” era “en general algo bueno” porque Google tiene usuarios en todo el mundo. “Pero aquí no ha dado en el blanco”, tuvo que reconocer la compañía.

¿Qué pudo haber causado que Géminis “fallara el tiro en el blanco”?

Los ejemplos fuera de lo común de Géminis podrían ser causados, según dijo Margaret Mitchell, ex codirectora de IA ética en Google y científica jefe de ética en el startup de IA ‘Hugging Face’, por haber estado agregando términos de diversidad étnica a las indicaciones de los usuarios“de forma oculta”.

En ese caso, un mensaje como “retrato de un chef” podría convertirse en “retrato de un chef indígena”. Google también podría dar mayor prioridad a la visualización de imágenes generadas en función del tono de piel más oscuro, dijo Mitchell.

Por ejemplo, si Gemini genera 10 imágenes para cada mensaje, Google haría que el sistema analizara el tono de piel de las personas representadas en las imágenes y colocara imágenes de personas con piel más oscura más arriba en la cola. De este modo, si Gemini solo nos puede mostrar 4 imágenes, es más probable que se vean los ejemplos de piel más oscura. Esta por ver como arregla Google el desaguisado.

Luis J. Merino

Técnico de sonido, melómano y amante de los dos pilares fundamentales del entretenimiento: cómic y videojuegos....